Als ich meinen Amiga 500 1990 bekam, war schon klar, dass die Speichererweiterung ein Muss ist. Ich denke die hatte ich von Anfang an.

Tja, wie gesagt, ich bin mir nicht sicher, ob die Angabe Quatsch ist. Je mehr ich drüber nachdenke (und nach ein bisschen Onlinelektüre), desto mehr denke ich, dass es eine Erweiterung auf vielleicht sogar 2 MB war. Aber wenn es keinen Amiga mit 1 MB ab Werk gab, dann war ich die meiste Zeit mit der Standardausgabe unterwegs.

Entschuldigung, wenn ich die blödeste Nachfrage der Welt stelle, aber bist du sicher? Es klingt natürlich sehr plausibel, nur frage ich mich langsam, ob ich überhaupt einen Amiga (oder eine Kindheit) hatte.

1991 ist der Amiga 500+ erschienen. Der hatte 1MB ab Werk.

Und den konnte man leicht auf 2 MB erweitern. Und da hat kaum ein Spiel von profitiert.

So steht es im Handbuch:

So wird das gewesen sein, zusammen mit einem 1084s Monitor für jeweils 500 DM. Das würde auch erklären, warum es keine große Rolle gespielt hat, ob der Schalter ein- oder ausgeschaltet war.

Wenigstens musste man sich nicht entscheiden, welche Version man kauft wie bei Sim City. Ich hatte damals nur 512k und musste die schlechter aussehende Version kaufen.

Aber irgendwann ging dann ohne 1 MB nichts mehr. Den Ausschalter habe ich nie nutzen müssen.

Ich musste aber bei 512k bei einem oder zwei Spielen das zweite Laufwerk abziehen. Jedes zusätzliche Laufwerk kostete etwas Speicherplatz.

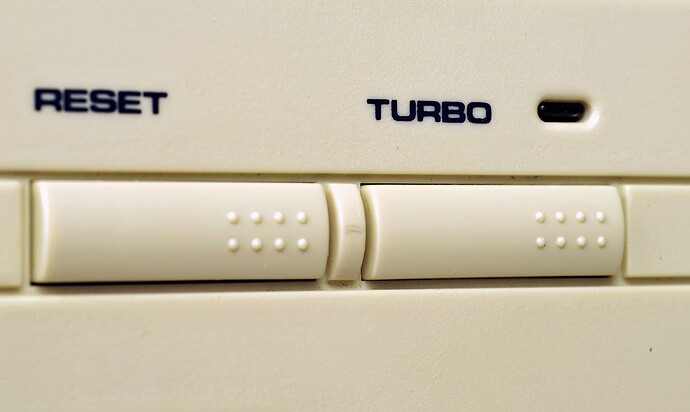

Ich habe bis zuletzt geglaubt, dass die Turbotaste den PC irgendwie beschleunigen würde. ![]()

Da der schnelle Turbo-Modus eigentlich der vorgesehene normale Betriebsmodus der CPU war, war die Turbo-Taste technisch keine Möglichkeit zum Beschleunigen, sondern eine solche zum Abbremsen. Als „Beschleuniger“ ließ sie sich aber viel besser vermarkten.

-Wikipedia

Es war wohl im Jahr 1999. Zu dieser Zeit kamen zwei Trends auf: Webcams für dieses Internet, Digicams für unterwegs. Es erschien mir damals vernünftig, beides zu kombinieren: mit einer Webcam von Creative Labs (deren Name mir leider entfallen ist), die sich nicht nur via USB an den PC anschließen, sondern mit Batterien auch als mobile Digitalkamera einsetzen ließ.

Vielleicht ist die Idee wirklich nicht schlecht. Aber die Umsetzung war grauenhaft. Davon abgesehen, dass in beiden Modi nur 640x480 möglich waren, damit konnte ich damals leben - die Bildqualität war entsetzlich, völlig verrauscht. Und wegen eines Firmware-Bugs war jedes Bild stark rotstichig. Super.

Ich habe die Kamera einen Tag lang als „Webcam“ (eigentlich hat sie offline ein paar Aufnahmen gemacht) und etwa fünf Minuten lang als Digicam eingesetzt, meine alte Analogkamera blieb noch für ein paar Jahre im Einsatz. Fehlkauf? Failkauf!

Oh je - ja, in den späten Neunzigern haben PC-Spieler in aller Welt wohl sehr viele Fehlkäufe getätigt (also praktisch immer, wenn eine 3D-Karte gekauft wurde, auf der nichts von 3dfx oder Nvidia stand).

Ich verweise nochmal auf meinen ersten Beitrag ![]() Diamond Edge 3D

Diamond Edge 3D ![]() 800 D-Mark

800 D-Mark ![]() unterstützte 4 Spiele

unterstützte 4 Spiele ![]()

![]()

![]()

Ich sag nur S3 Virge. So einen Schrott hatte ich damals.

Ugh, ich hatte als Grafikkarte eine Matrox Parhelia gekauft. Das war der lang erwartete Nachfolger der viel besungenen Matrox G400/G450, die ich auch hatte und mir der ich grundzufrieden war, und Matroxs Versuch in den Markt modernerer 3D-Beschleuniger einzusteigen.

Das Ding war vor Erscheinung imposant angekündigt. Matrox kannte man als „professionelle“ GPU, und dementsprechend kam das Ding mit so Profi-Features wie Glyph Acceleration (zum schnelleren Rendern von Text!), 32-bit Farbtiefe (10 bit pro RGB, 2 bit für Alpha) statt der üblichen 24 bit, und der Fähigkeit ganze drei Bildschirme anzuschließen. Das war zu einer Zeit, wo selbst zwei Bildschirme noch nicht super üblich waren, der absolute Wahnsinn.

Leider stellte sich die 3D-Performance des Dings bei Erscheinung als enttäuschend heraus, und die kurz danach erschienene Radeon 9700 hat das Teil völlig in den Schatten gestellt.

Vermutlich auch aus Konsequenz dessen, lief die Grafikkarte fast nie so richtig mit modernen Spielen. Die Anzahl der Parhelia-Inhaber blieb für Spielehersteller wohl nur ein Rundungsfehler. Manche Spiele verweigerten komplett den Dienst, andere starteten, aber hatten sehr kaputte Ausgabe.

Ich weiß noch, wie ich damals das MMORPG „City of Heroes“ für ein paar Tage gespielt habe… komplett ohne Texturen! Ich wusste nicht, wie mein Superheld wirklich aussieht, und hab mir von anderen Spielern Screenshots schicken lassen!

Und der Linux-Treiber war sehr closed source, und sehr buggy. Brachte den PC häufig komplett zum Abstürzen und so Scherze. Extra ärgerlich, weil ich doch Matrox vor allem treu geblieben war, weil eben die G450 und andere Vorgänger so unverschämt gut unter Linux liefen.

Viel Geld dafür ausgegeben. Deswegen lange behalten, und unglaublich viel Zeit und Energie verschwendet, aus dem Ding vergebens was rauszuholen. Vermutlich mein größter Fehlkauf.

Also ich hatte sogar die 2mb Variante - und habe sie ernsthaft ausgenutzt ![]() (nicht für Spiele, da brachten mehr als 1mb eher nichts mehr)

(nicht für Spiele, da brachten mehr als 1mb eher nichts mehr)

Oh ja - ich erinnere mich vor allem daran, wie mich das 256-Bit-Speicherinterface beeindruckt hat. Das war ja noch einige Monate vor der Radeon 9700.

Die Parhelia war eine ähnliche Enttäuschung wie Matrox’ erster Versuch auf dem 3D-Beschleuniger-Markt, die M3D mit PowerVR-Chip. Ich hatte damals eine Mystique und war mit dem 2D-Part zufrieden, aber für 3D-Spiele wurde es dann doch eine Voodoo. Kein Fehlkauf!

In meinem ersten Windows-PC steckte auch eine Mystique.

Ich habe den ganzen PC ohne große Ahnung nach Gutdünken zusammengestellt. Die Mystique habe ich wegen des geilen Namens und des Spielebundles (MechWarrior2, DestructionDerby2) ausgewählt.

MW2 war ein top Spiel. Aber DD2 lief in der Matrox-Version schlechter als die unoptimierte Demoversion mit Software-Renderer.

Und später gab es bei Toonstruck einen Bug, dass man das Aquarium nicht vor dem Fisch erreichen konnte. Jahre Später gab es ein Treiberupdate für die Mystique, das dieses Problem behob.

Wenn man sich die Mystique angeschafft hat weil man mehr Performance in Spielen haben wollte, war das ein Fehlkauf. Denn außer den Spielen im Bundle gab es sonst nicht viel, was für diese Karte optimiert war.

Ansonsten hat die Karte aber ganz ordentlich funktioniert. Und es kamen ein paar nette Tools mit der Karte mit. So konnte man die Desktop-Auflösung und Farbtiefe ohne Neustart ändern und die Position der Desktop-Icons wurde dabei nicht durcheinander gewürfelt.

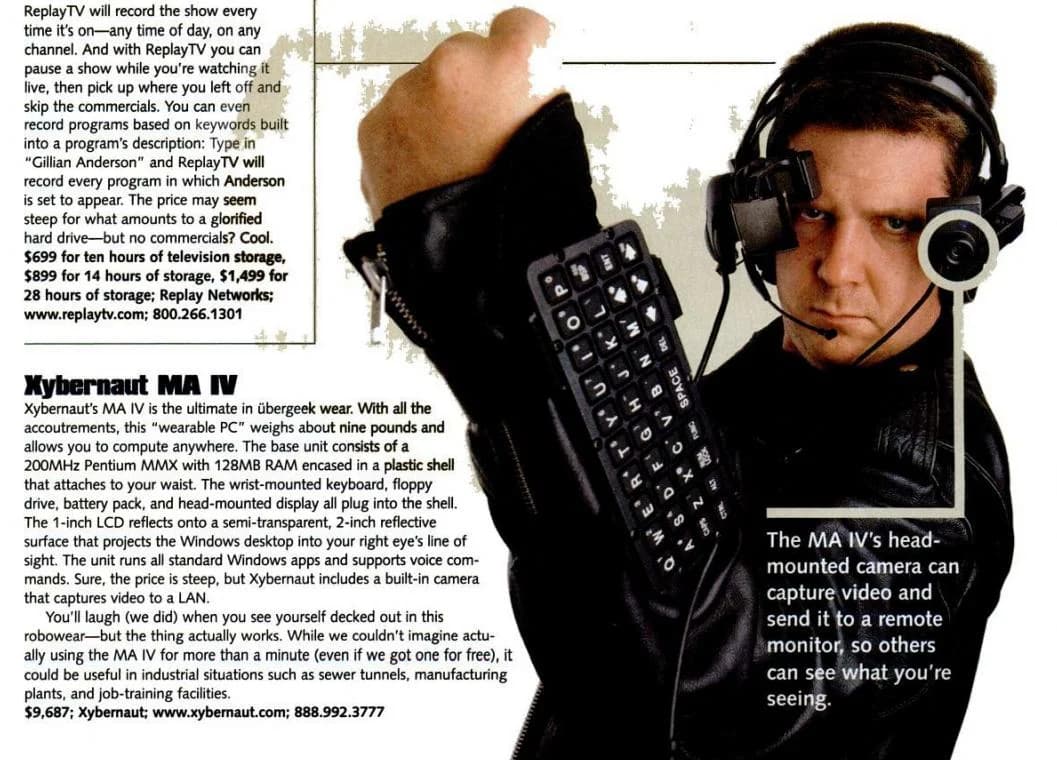

Richtig wild waren auch die Produkte von Xybernaut! (Alleine der Name…)

Für nur 9.687 Dollar konnte man seinen Körper mit einem ca. 4 Kilo leichten Computer behängen. Der Rechner samt Batterie, die Saft für 90-120 Minuten Betrieb hatte, wird am Gürtel getragen. Das Display wird natürlich am Kopf getragen. Zur Steuerung hat man sich eine Tastatur um den Arm geschnallt und einen Bewegungscursor zur Maussteuerung in der Hand gehabt.

So sah man wie ein echter Xybernaut aus.

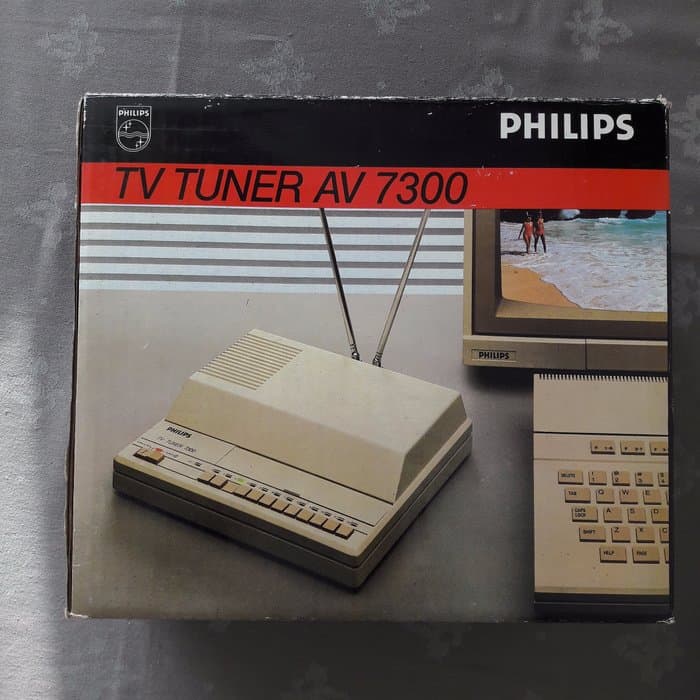

Nicht wirklich eine Sünde, aber ich wollte nur mal kurz berichten, dass mein Bruder und ich damals diesen Philips TV Tuner hatten und so auch indirekt den ersten eigenen Fernseher im Kinderzimmer. Man hat den Monitor angeschlossen, die Antennen ausgerichtet und dann die Sender mit kleinen Rädchen kalibriert. So konnte man ganze 12 Sender auf Knopfdruck speichern. Der Empfang war mit Antenne natürlich nicht allzu dolle, aber ich konnte damit RTL Samstag Nacht gucken während mein älterer Bruder in der Disko tobte. ![]()

Das Teil war bei uns relativ lange in Gebrauch. Ich kann mich noch daran erinnern damit TV Total eingeschaltet zu haben als es noch wöchentlich lief ('99-2000) und man sich mit 2-3 Leuten gemeinsam vor den 14 Zoll großen Commodore Monitor versammelt hat, um Raabs neueste Streiche zu gucken.

Das war was!

Boah, ich erinnere mich noch genau an das Ding im Katalog! Wollte das auch haben, sogar auch für meinen 14" Commodore 1084S, aber letztendlich hab ich dann über die Kurz & Fündig sehr günstig einen Videorekorder bekommen, und mit dem ging das dann genau so. Hatte dann sogar eine Fernbedienung.

(Mein Videorekorder gehörte zum Glück nicht zu denen die sich ohne Band, oder falls das Band nicht gespielt wurde, nach einer Weile von selbst ausschalteten.)

Das hatten echt einige Leute damals ![]()